Элиезер Юдковский, канский аналитик и критик технологий искусственного интеллекта, выступил с заявлением о необходимости немедленного отключения самообучающихся систем, пишет The Time.

В своей новой колонке для журнала Time Юдковский подчеркнул, что подпись известных бизнесменов, таких как Илон Маск и Стив Возняк на письме о возможных угрозах, не может снизить всю серьезность ситуации, и что этого недостаточно.

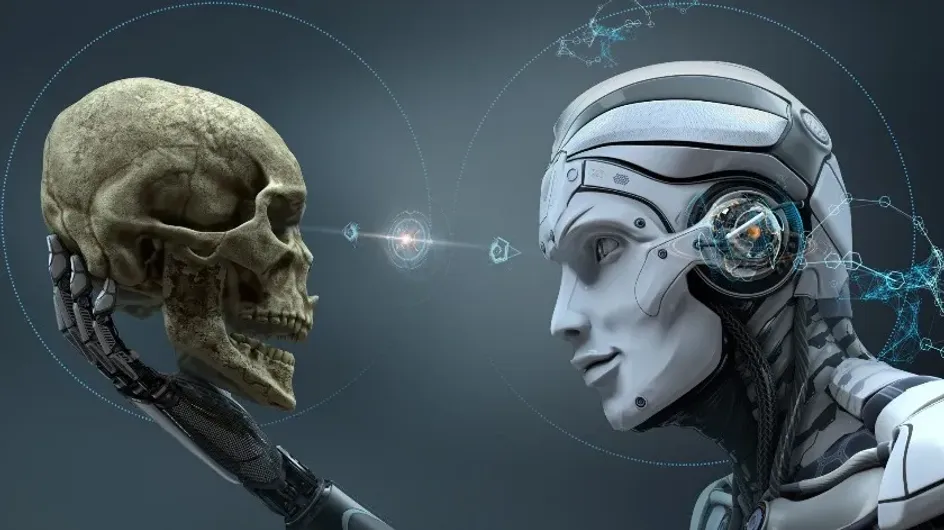

Он считает, что появление сверхчеловечески интеллектуальной компьютерной модели может привести к гибели человечества, так как такие системы не будут следовать интересам и благополучию общества в целом.

Юдковский предлагает запрет на дальнейшее развитие технологий искусственного интеллекта для правительственных организаций и вооруженных сил, а также на бессрочное использование этой технологии в целом.